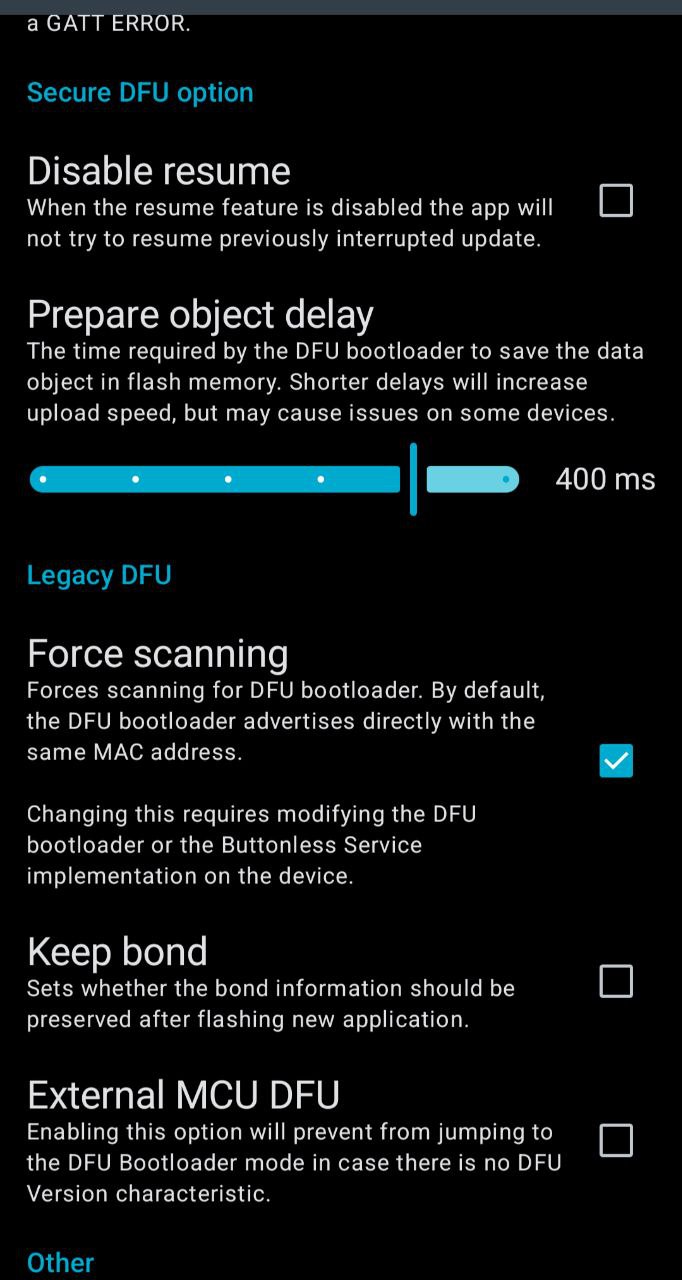

Mit Meshcore lassen sich nRF52840-basierte Repeater inzwischen bequem Over-the-Air (OTA) aktualisieren. Voraussetzung dafür ist ein passender Bootloader...

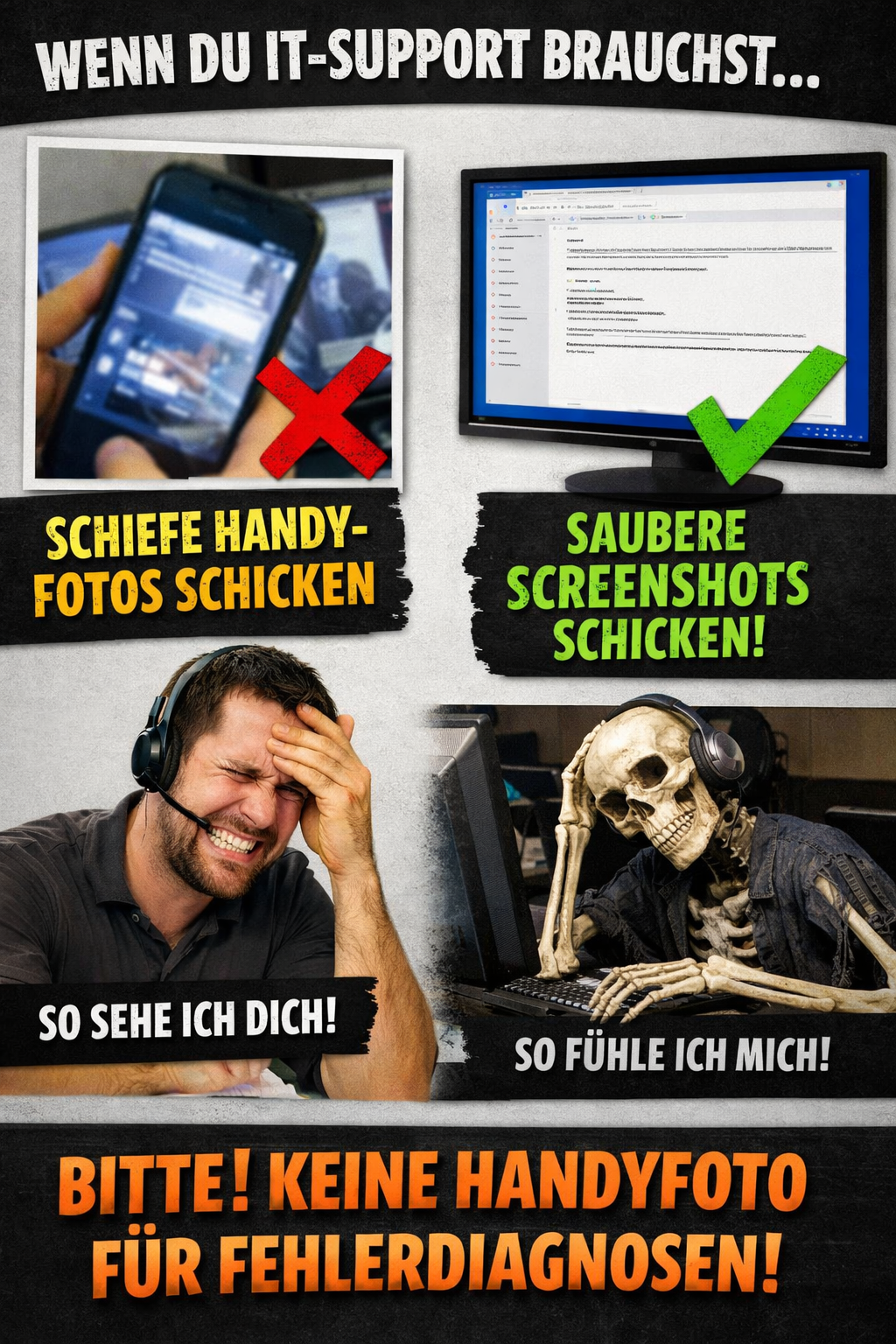

Ich mache inzwischen für überraschend viele Menschen IT-Support. Offiziell passiert das meist zufällig, inoffiziell hat sich das...

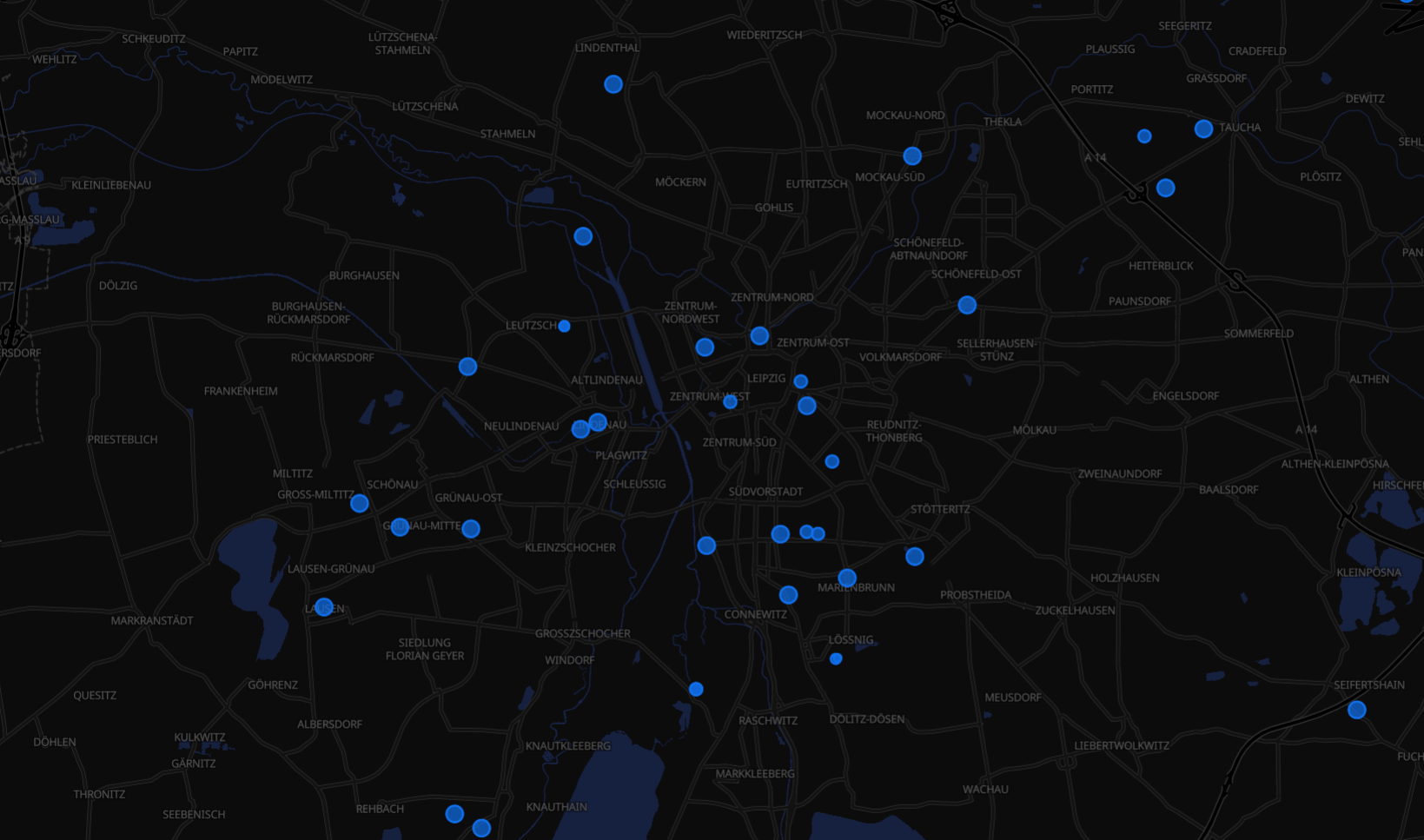

Der MeshCore Analyzer auf analyzer.letsmesh.net ist ein Visualisierungs- und Analysewerkzeug für LetsMesh bzw. MeshCore Netzwerke. Das Tool...

Ubuntu 22.04: Standard Dokumentenbetrachter druckt keine PDFs Unter Ubuntu 22.04 kann es vorkommen, dass der Standard-Dokumentenbetrachter Evince...

Wake-on-LAN über Synology DiskStation nach DSM 6 Update Viele nutzen ihre DiskStation nicht nur als Datenspeicher, sondern...

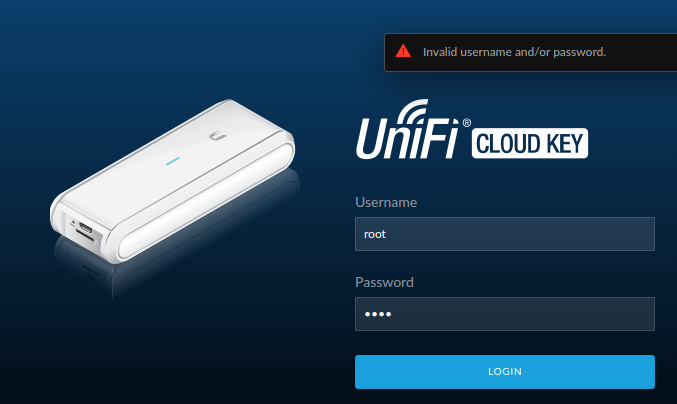

Obwohl ihr euch sicher seid, dass ihr das richtige Kennwort nutzt, kommt ihr nicht in den Cloud...

Dymo LabelWriter 450 unter Linux (Ubuntu 25.10) einrichten Leider gibt es für den Dymo LabelWriter 450 keinen...

Meshtastic hat in den vergangenen Jahren vielen Menschen gezeigt, wie einfach es sein kann, mit günstiger Hardware...

Standardmäßig legt Firefox neue Tabs ganz rechts in der Tableiste ab. Wer viele Tabs gleichzeitig nutzt, verliert...

Mit dem Release von Proxmox VE 9 steht ein großes Upgrade bevor. Wer noch auf Version 8...